Compacting地獄からの脱出

あの厄介なCompacting

Claude Codeを長く使ってきた方なら、きっと共感していただけると思います。

作業中に突然表示されるあのメッセージ、「Compacting conversation…」。これが出た瞬間、ヒヤッとするんです。会話が圧縮されて、それまでのコンテキストが飛んでしまうので。

特にPDFを大量に読み込む作業が厄介でした。膨大なドキュメントを読ませると3〜4回も圧縮が起きて、運が悪いとエラーで落ちてしまうこともありました。だから常に「これを送ったらCompactingが走るかな…」と計算しながら使っていたんです。

地味にストレスなんですよね。AIに仕事を任せているはずなのに、逆にAIのコンテキスト容量を管理している状態ですから。

ある日Switch Modelを押してみたら

今日も一度に読まないといけないPDFが多すぎました。いつも通りもたつき始めて「またか」と思ったのですが、ふとSwitch Modelをクリックしてみました。

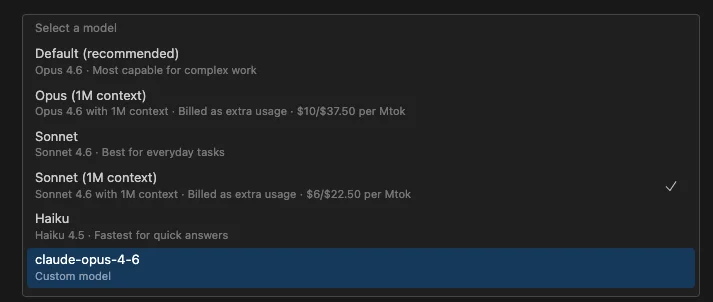

あれ?モデルごとに1M contextオプションが追加されている?

少し前までClaude Codeに正式にはなかったはずなのに。Opus (1M context)、Sonnet (1M context)と、それぞれ別に選択できるようになっていました。

切り替えたら世界が変わった

切り替えた直後の感想。「何これ?」

今までは読んでは圧縮、また読んでは圧縮、そのうちコンテキストがめちゃくちゃになって変な結果が出て…の繰り返しでした。でも1M contextに切り替えたら、大量のPDFを一気に読み込んで処理してしまうんです。

Compactingが来るかどうかビクビクしていた、あのストレスが完全になくなりました。

体感の差が本当にすごいです。同じツールなのに、コンテキストウィンドウひとつでこんなに変わるのかと驚きました。

でもタダじゃない

当然、良いものにはお金がかかります(笑)

1M contextモデルはextra usageとして追加料金が発生します。スクリーンショットを見ると、Opus (1M context)は$10/$37.50 per Mtok、Sonnet (1M context)は$6/$22.50 per Mtokと表示されています。

AIサブスクリプション費用については以前も書きましたが、追加費用を払ってでも、たまに切り替えて使う価値は十分あると感じました。毎日1Mで使う必要はなくて、PDFを大量処理するときだけ切り替えればいいんです。

Claudeが高くても使い続ける理由

Claude Codeを長期間使ってきて気づいたことがひとつあります。

他のAIより常に20%くらい高く設定されているんです。容量もちょっとケチです。Opencodeのようなオープンソースの代替も出ていますし、Cursorも試しましたし、いろいろなツールを比較してきました。

でも結局Claude Codeに戻ってくるんです。

理由はシンプルです。確実な性能を保証してくれるということ。値段相応の結果が返ってきます。コードの理解力、コンテキストの把握能力、エージェントモードの完成度…これらの面では、まだClaude が一枚上手だと感じています。

これがClaude を使い続ける原動力なのだと思います。

1Mが標準になる日が来るはず

今後AIがさらに発展して、1M contextがデフォルトになれば…作業が本当に楽になるでしょう。今はextra usageで追加料金を払っていますが、数年経てば200Kがそうだったように、1Mも当たり前になるはずです。

そうなれば、Compactingを心配せずにプロジェクト全体を一度に渡して、数百ページのドキュメントも一発で処理して…想像するだけでワクワクします。

とにかく、今すぐ大容量の作業が必要な方は、Switch Modelで1M contextオプションを試してみてください。コストはかかりますが、Compacting地獄から解放される開放感はプライスレスです。

Agent Teamsと組み合わせたら?

もうひとつ。最近Claude CodeにAgent Teams機能がリリースされました。複数のエージェントを同時に立ち上げて、それぞれ独立して作業し、お互いにコミュニケーションまでできる機能です。

これと1M contextを組み合わせたらどうなるか、考えてみました。

重い作業、例えば数百ページのドキュメント分析やプロジェクト全体の把握が必要なエージェントには1M contextモデルを割り当てて、簡単なファイル修正やテスト実行のような軽い作業にはHaikuのような高速モデルを割り当てる。重いものは重く、軽いものは軽く。作業の性質に応じてモデルを分配する方式です。

まだAgent Teams自体が実験的機能なので、こういった組み合わせを完璧にセットアップするのは難しいですが、方向性は確実にこちらだと思います。AIが一人で働く時代から、AIがチームで働く時代に移行しているわけですから。

1M context + Agent Teamsが当たり前になる日が来たら、開発の生産性は今とは次元が違うものになるでしょう。